enable.idempotence=true garantiert dir, dass die vom Producer gesendeten Nachrichten genau einmal und in der richtigen Reihenfolge übermittelt werden. Es garantiert jedoch nicht, dass ein Consumer die Nachricht genau einmal verarbeitet. Dafür musst du Transaktionen verwenden.

Apache Kafka Clients richtig konfigurieren

Apache Kafka ist eine leistungsstarke und stabile Plattform. Allerdings sind viele der „Out-of-the-Box“-Einstellungen nicht wirklich eine solide Grundlage für die Produktion. Viele dieser Standardeinstellungen sind das Ergebnis historischer Entscheidungen und wurden aus Gründen der Abwärtskompatibilität beibehalten. In diesem Artikel geben wir dir eine Reihe von Empfehlungen, die auf unserer umfangreichen Erfahrung basieren.

Dieser Leitfaden handelt nicht von Hyper-Optimierung für Konzerne wie LinkedIn oder Netflix, bei denen Millionen von Nachrichten pro Sekunde die Norm sind. Es geht um eine Handvoll entscheidender Konfigurationsänderungen, die deinen Kafka-Cluster in Standard-Umgebungen zuverlässiger, robuster und einfacher zu betreiben machen.

Producer-Konfiguration

Mit diesen Konfigurationseinstellungen sorgst du dafür, dass deine Producer Daten zuverlässig und performant senden.

-

acks=all: (Standard seit ~Kafka 3.4) Stellt sicher, dass der Producer wartet, bis die Nachricht in alle In-Sync-Replicas geschrieben wurde. -

enable.idempotence=true: (Standard seit ~Kafka 3.4) Stellt sicher, dass Nachrichten genau einmal gesendet werden. Überlebt sogar Broker-Neustarts.

-

delivery.timeout.ms: (Standard:120000(2 Minuten)) Der Producer wird für diese Zeitspanne versuchen, die Nachricht zu senden. Nach diesem Timeout gibt der Producer auf und wirft einen Fehler.

Wenn du nach dem Timeout einfach in deinem eigenen Code einen erneuten Versuch startest, wäre es besser, wenn du einfach die delivery.timeout.ms erhöhst. Lies mehr über Zuverlässigkeit in diesem Artikel über zuverlässige Producer.

-

client.id={hostname}: (Standard: automatisch generiert) Setze diese Einstellung für besseres Monitoring und besseres Logging. Wenn du Kubernetes verwendest, setze es auf den Hostnamen des Pods.

Durchsatz-Optimierung

Für die meisten „Medium Data“-Anwendungen kannst du einen erheblichen Performance-Schub erzielen, indem du deine Nachrichten batchst und komprimierst, ohne (zu viel) Latenz zu opfern.

-

batch.size= z.B. 900000: (Standard:16KiB) Dieser Wert ist für die meisten Anwendungsfälle zu klein. Erhöhe ihn auf bis zu 1 MB. Dies ermöglicht es deinem Producer, mehr Daten in einer einzigen Netzwerkanfrage zu senden, was den Overhead reduziert und den Durchsatz verbessert. -

linger.ms=5, 10 oder 100: (Standard:0ms) Diese Einstellung arbeitet Hand in Hand mitbatch.size. Sie weist den Producer an, bis zu einer bestimmten Zeit (Standard: 0 ms) zu warten, bis sich ein Batch gefüllt hat, bevor er es sendet. Eine Erhöhung auf wenige Millisekunden kann den Durchsatz erheblich verbessern, ohne die Latenz stark zu beeinträchtigen. -

compression.type=lz4 oder zstd: (Standard:none) Das Komprimieren deiner Nachrichten, bevor sie an Kafka gesendet werden, kann die Netzwerkbandbreite sparen und den Durchsatz verbessern. Mit Algorithmen wie LZ4 oder Zstd kannst du hervorragende Ergebnisse erzielen.

Weitere Einstellungen

-

transactional.id={hostname}: Diese Einstellung wird nur benötigt, wenn du Producer-Transaktionen verwendest. Dietransactional.idmuss für jede Producer-Instanz eindeutig, aber über Neustarts hinweg persistent sein. Wenn eine Producer-Instanz neu startet, verwendet Kafka diese ID, um zu verhindern, dass „Zombie“-Producer Transaktionen committen. Nutze in Kubernetes StatefulSets für transaktionale Producer.

In Kubernetes solltest du StatefulSets für deine transaktionalen Producer verwenden.

-

partitioner=murmur2_random: (Standard:Murmur2Partitionerin Java,consistent_randomin librdkafka) Der Partitioner bestimmt, an welche Partition eine Nachricht gesendet wird. Wenn du sowohl Java- als auch Nicht-Java-Producer verwendest, stelle bitte sicher, dass alle Producer den Partitioner aufmurmur2_randomsetzen, um eine konsistente Partitionierung zu gewährleisten.

Wenn du sowohl Java- als auch Nicht-Java-Producer verwendest, stelle bitte sicher, dass alle Nicht-Java-Producer den Partitioner auf murmur2_random setzen, um eine konsistente Partitionierung zu gewährleisten.

Consumer-Konfiguration

Mit diesen Konfigurationseinstellungen bekommst du zuverlässige und performante Consumer für 99% der Anwendungsfälle.

-

group.id={service-name}: Alle Consumer, die zur selbengroup.idgehören, arbeiten als eine Einheit zusammen, um Nachrichten von einem Topic zu konsumieren. Verwende einen klaren, beschreibenden Namen für deine Consumer-Gruppe, z. B. den Namen deines Dienstes. -

client.id={hostname}: Ähnlich wie beim Producer ist es auch beim Consumer wichtig, für Monitoring und Debugging eine aussagekräftige ID zu vergeben. -

group.protocol=consumer: (Standard:classic) Verwende die neue Generation des Consumer-Rebalance-Protokolls (lies KIP-848 für weitere Informationen). Erfordert Kafka 4.0 oder höher. Macht das Rebalancing viel schneller!

Wenn du eine Kafka-Version älter als 4.0 verwendest, kannst du das neue Consumer-Rebalance-Protokoll nicht nutzen. Dann musst du das alte classic-Protokoll verwenden. Aber um die Rebalancing-Geschwindigkeit zu verbessern, kannst du die Einstellung partition.assignment.strategy=CooperativeStickyAssignor setzen: (Standard: RangeAssignor, CooperativeStickyAssignor)

-

isolation.level=read_committed: (Standard:read_uncommitted) Stellt sicher, dass dein Consumer-Code niemals Nachrichten aus nicht abgeschlossenen oder abgebrochenen Transaktionen sieht. Es ist eine Best Practice, diese Einstellung standardmäßig auf allen Consumern zu setzen, auch wenn du derzeit keine Transaktionen verwendest.

Wenn dein Producer transaktional ist und dein Consumer mit isolation.level=read_uncommitted konfiguriert ist, kann dies zu schwerwiegenden Datenintegritätsproblemen führen, da Daten aus fehlgeschlagenen Transaktionen gelesen werden. Verwende immer read_committed.

-

auto.offset.reset=earliest: Diese Einstellung bestimmt, was zu tun ist, wenn ein Consumer startet und keinen gültigen Offset für eine Topic-Partition findet. Wenn du möchtest, dass deine Consumer alle Nachrichten von Anfang an lesen, setze es aufearliest. Wenn du nicht alle Nachrichten lesen möchtest und es in Ordnung ist, einige zu verpassen, setze es auflatest. -

enable.auto.commit=true: (Standard:true) Handhabt automatische Offset-Commits. Deaktiviere dies nur, wenn du genau weißt, was du tust (zum Beispiel wenn du Offsets innerhalb einer Transaktion händisch committest). -

commit.interval=5000: (Standard:5000) Diese Einstellung bestimmt, wie oft der Offset eines Consumers an Kafka committet wird. Der Standardwert beträgt 5 Sekunden, was bedeutet, dass im Falle eines Absturzes höchstens 5 Sekunden Daten erneut verarbeitet werden. Du solltest dies nur ändern, wenn du einen sehr guten Grund dazu hast.

Wenn du eine exactly-once Verarbeitung benötigst, musst du entweder eine Consume-Process-Produce-Schleife mit Transaktionen verwenden oder Kafka Streams mit der Einstellung processing.guarantee=exactly_once_v2.

Rebalances in Kubernetes vermeiden und Kosteneffizienz steigern

Rebalances finden statt, wenn Consumer einer Consumer-Gruppe beitreten oder sie verlassen. In automatisierten Infrastrukturen wie Kubernetes werden Ausfälle von Pods von der Infrastruktur übernommen, und wir können teure Rebalances in Kafka vermeiden.

-

group.instance.id={hostname}: Stellt sicher, dass ein Consumer sich nach einem Neustart an sein vorheriges Assignment "erinnert" und somit teure Rebalances vermieden werden. Aber: Der Neustart muss innerhalb dersession.timeout.msstattfinden. -

session.timeout.ms= z.B. 60000: (Standard:30000) Diese Einstellung definiert die maximale Zeit, die ein Consumer nicht verfügbar sein darf, bevor er als ausgefallen betrachtet wird und die Consumer-Gruppe rebalanced wird. Erhöhe diesen Wert auf einen Wert, bei dem ein Consumer seinen Ausfall leicht erkennen, herunterfahren und den Pod neu starten kann. Konfiguriere die Einstellung nur zusammen mitgroup.instance.id.

group.instance.id und session.timeout.ms sollten zusammen verwendet werden und ergeben nur Sinn, wenn du ein StatefulSet für deine Consumer in Kubernetes verwendest, damit die Identität des Pods den Neustart überlebt.

-

client.rack={dc-name}: Wenn du deinen Kafka-Cluster und deine Clients in einer Cloud-Umgebung mit mehreren Verfügbarkeitszonen (AZ) betreibst, kannst du dieclient.racksowohl auf den Brokern als auch auf den Consumern festlegen. Dies ermöglicht es dem Consumer, es zu bevorzugen, von einer Replica in derselben AZ zu lesen, was die Datenübertragungskosten zwischen den AZs erheblich senken kann.

Topic-Konfiguration

Hier findest du die Grundkonfiguration für deine Topics.

Zuverlässigkeit und Performance

-

num partitions: Die Anzahl der Partitionen wirkt sich direkt auf die Parallelität und Skalierbarkeit deines Topics aus. Die Faustregel lautet, mindestens so viele Partitionen wie Mitglieder deiner Consumer-Gruppe zu haben. Für eine detailliertere Anleitung schaue dir unseren Artikel zu diesem Thema an. -

replication-factor=3: (Standard:1) Die Anzahl, wie oft die Daten einer Partition über Broker hinweg repliziert werden. 3 ist der Goldstandard für die meisten Produktionsumgebungen, da er eine hohe Verfügbarkeit zu vernünftigen Kosten bietet. -

min.insync.replicas=2: (Standard:1) Wie viele In-Sync-Replicas verfügbar sein müssen, damit Producer in eine Partition schreiben können. Bei einem Replikationsfaktor von 3 bedeutet ein Wert von 2, dass ein Broker ausfallen kann, ohne die Produktion zu beeinträchtigen, und ein weiterer ausfallen kann, ohne Daten zu verlieren.

Datenaufbewahrung und Lebenszyklus

-

cleanup.policy: (Standard:delete) Dies definiert, wie Kafka mit alten Nachrichten umgeht. Der Standardwert istdelete, was bedeutet, dass Nachrichten nach einer festgelegten Zeit gelöscht werden. Für Anwendungsfälle wie Change Data Capture oder Event Sourcing könntest ducompactverwenden, was alte Nachrichten für denselben Key entfernt. -

retention.hours: (Standard: 168 Stunden (7 Tage)) Diese Einstellung steuert, wie lange Kafka Nachrichten aufbewahrt, bevor sie gelöscht werden. Der Standardwert beträgt 7 Tage, aber du solltest diesen basierend auf deinen Business-Anforderungen anpassen.

Fazit

Leider sind in Kafka die Standardeinstellungen oft nicht „gut genug“ für die Produktion. Ich hoffe, dieser Artikel hat dir geholfen, die richtigen Einstellungen für deine Produktionsumgebung zu finden. Wenn du Fragen hast, kannst du uns jederzeit kontaktieren.

Weiterlesen

Plattform-Engineering, Cloud-Kosten und das "Copy-Paste-Problem": Alex Kropp im Interview

Alexander Kropp, Plattform-Ingenieur bei der DataFlow Academy, spricht im Interview über Cloud-Kosten, das "Copy-Paste-Problem" bei Tech-Stacks und warum Plattform-Teams die wichtigsten Tech-Multiplikatoren im Unternehmen sind.

Mehr lesen

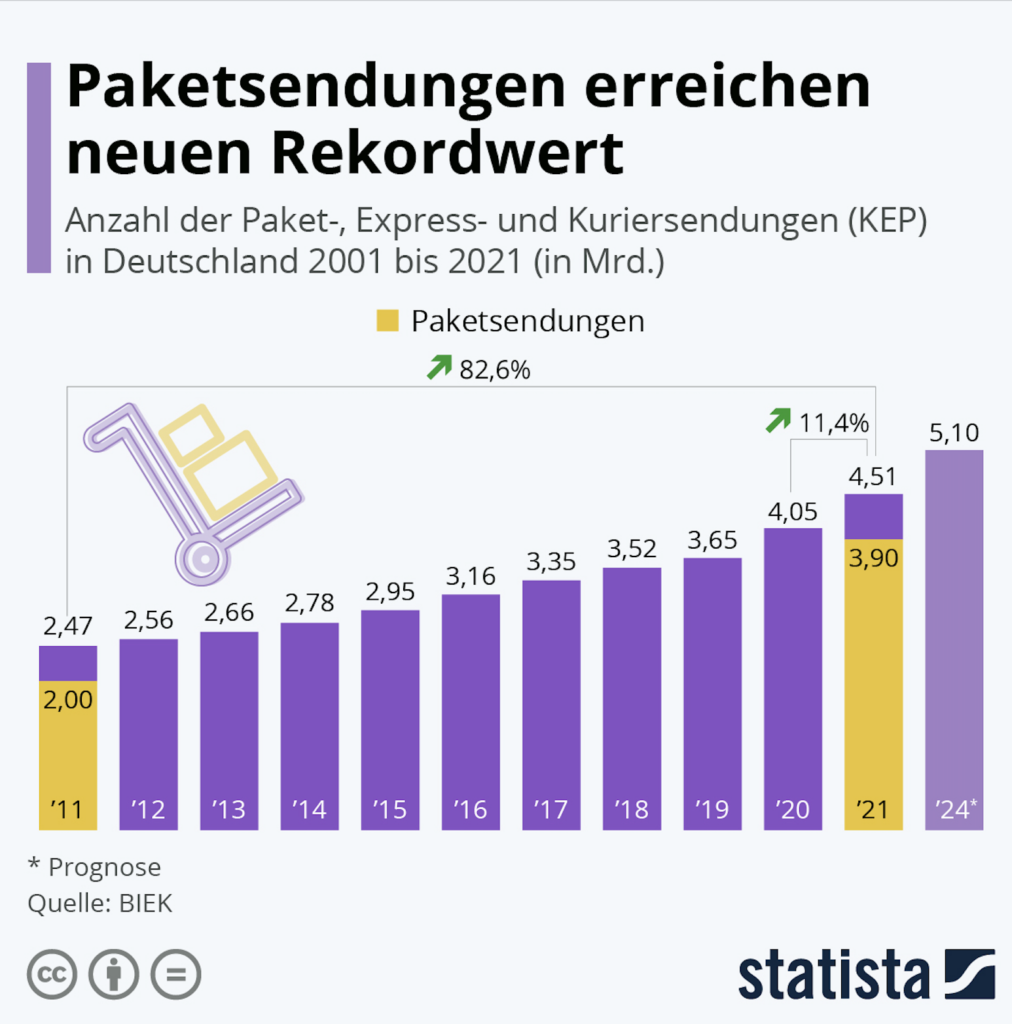

Logistik: Wie die Branche mit Kafka wachsenden Belastungen trotzen kann

Wachsende Paketmengen. Poröse Lieferketten. Logistikfirmen stehen vor großen Problemen. Sie müssen mehr denn je in Echtzeit die richtigen Entscheidungen treffen. Das gelingt jedoch nicht ohne Echtzeitdaten. Wie Apache Kafka und dessen Ökosystem Unternehmen dabei helfen.

Mehr lesen